"

["post_title"]=>

string(96) "AI経由のkintoneデータ流出を防ぐ!「データ学習・漏洩」のリスクと対策"

["post_excerpt"]=>

string(0) ""

["post_status"]=>

string(7) "publish"

["comment_status"]=>

string(6) "closed"

["ping_status"]=>

string(6) "closed"

["post_password"]=>

string(0) ""

["post_name"]=>

string(27) "generative-ai-data-security"

["to_ping"]=>

string(0) ""

["pinged"]=>

string(0) ""

["post_modified"]=>

string(19) "2026-01-21 17:21:22"

["post_modified_gmt"]=>

string(19) "2026-01-21 08:21:22"

["post_content_filtered"]=>

string(0) ""

["post_parent"]=>

int(0)

["guid"]=>

string(45) "https://adiem.jp/?post_type=blog&p=15850"

["menu_order"]=>

int(0)

["post_type"]=>

string(4) "blog"

["post_mime_type"]=>

string(0) ""

["comment_count"]=>

string(1) "0"

["filter"]=>

string(3) "raw"

}

}

["post_count"]=>

int(2)

["current_post"]=>

int(-1)

["before_loop"]=>

bool(true)

["in_the_loop"]=>

bool(false)

["post"]=>

object(WP_Post)#1074 (24) {

["ID"]=>

int(15991)

["post_author"]=>

string(2) "13"

["post_date"]=>

string(19) "2026-02-16 08:00:27"

["post_date_gmt"]=>

string(19) "2026-02-15 23:00:27"

["post_content"]=>

string(15987) "

kintone連携でn8nを使いたいけど、パスワードを預けて本当に大丈夫?

kintoneに蓄積したデータをもっと活用したい、AIで業務を効率化したい。そう考えて連携ツールを調べるうちに、n8n(エヌエイトエヌ)の存在を知った方も多いでしょう。

しかし、導入を検討する中で「海外製のツールに、社内の大切なデータや認証情報を預けても大丈夫なのか?」という不安がよぎるかもしれません。実際、インターネット上には「n8nは危険」といった断片的な情報も見受けられ、迷いが生じてしまうのは当然のことです。

この記事では、そんな疑問を解消するために「n8nは本当に安全なのか」「どうすれば安心して使えるか」を、初心者向けにわかりやすく解説します。

n8nは世界標準の監査と「銀行レベルの暗号化」で安全性を確保

n8nは、世界的に認められたセキュリティ基準をクリアしています。認証情報(APIキー等)は銀行システムと同等の暗号化技術で保護されるため、適切に設定すれば安心して利用可能です。

ただし「正しく設定すれば」という条件がポイントになります。セキュリティ機能は備わっていても、設定を誤れば効果を発揮しません。この記事で解説する設定方法を押さえておけば、安全にn8nを活用できます。

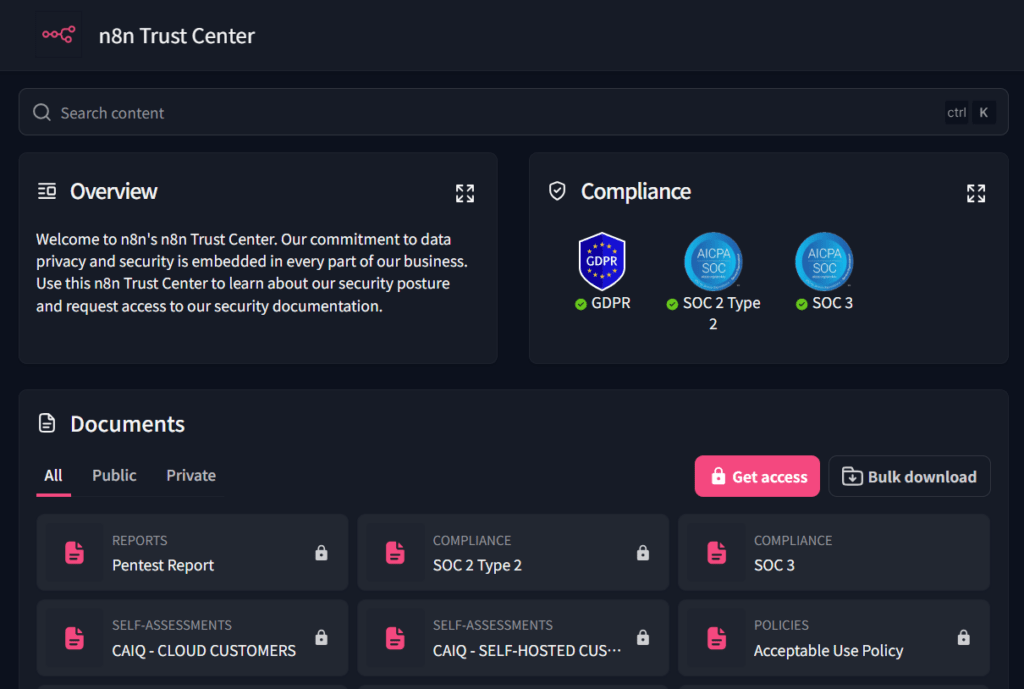

SOC 2(第三者審査)を毎年クリアし、信頼性を証明

n8nの運営元は、

SOC 2 Type IIという国際的なセキュリティ認証を取得しています。SOC 2とは、米国公認会計士協会が定めた情報セキュリティの監査基準です。顧客データの保護体制が第三者機関によって審査され、毎年更新が求められます。

n8n社は

Trust Centerを公開しており、セキュリティへの取り組みを透明化しています。「無料ツールはセキュリティが甘い」というイメージを持つ方もいるかもしれませんが、n8nはこの認証によって企業レベルの信頼性を証明しているのです。

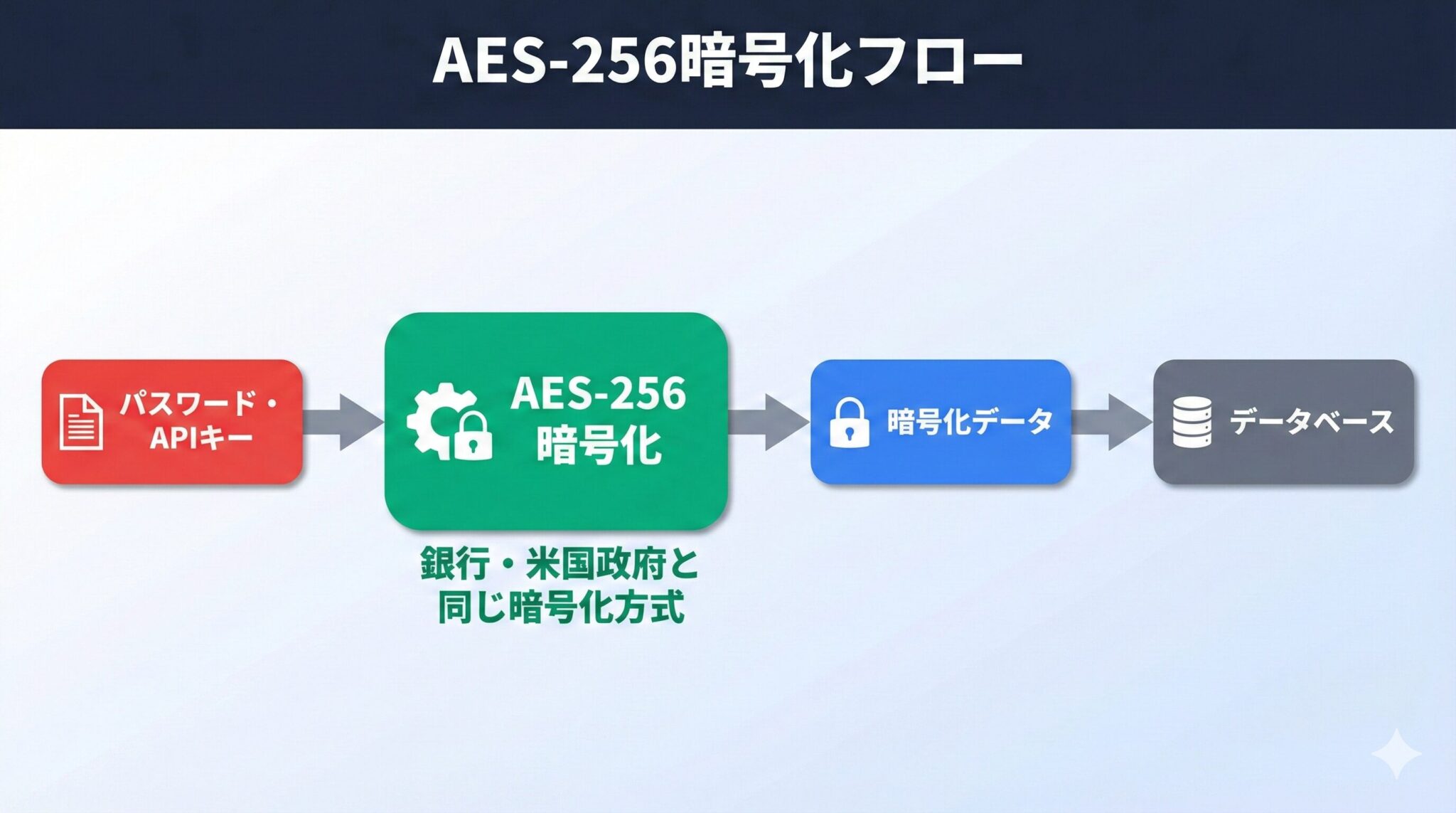

APIキーはAES-256で暗号化。銀行と同じ技術で守られる

n8nに登録したパスワードやAPIキーは、AES-256という暗号化方式で保護されます。AES-256は米国政府の機密情報や銀行システムでも採用されています。現時点で最も信頼性の高い暗号化技術のひとつです。

平文(そのままの文字列)でAPIキーが保存されることはありません。クラウド版では暗号化が自動的に適用されるため、特別な設定は不要です。

ただし、セルフホスト版を利用する場合は、環境変数の設定が必要になります。詳しくは後述の「補足」で解説しています。

パスワードはAzure上で暗号化保存。画面にも表示されない

n8nが安全と言える理由は、データの「保存」と「通信」の両面で暗号化が施されているからです。パスワードやAPIキーは、登録後に画面上で確認することもできません。

パスワードは入力後すぐ暗号化。入力者も見られない状態に

n8nには「Credentials(クレデンシャル)」という、パスワードやAPIキーを安全に保管する専用機能があります。一度登録すると、画面上には伏せ字で表示され、中身を見ることはできなくなります。

この仕組みにより、たとえ画面を覗き見されても認証情報が漏れる心配がありません。保管時はAES-256で自動的に暗号化されるため、データベースに直接アクセスされた場合でも、暗号化キーがなければ解読は不可能です。

データは大手クラウド(Microsoft Azure)で厳重に管理

クラウド版n8nのデータは、

Microsoft Azureのデータセンター(ドイツ・フランクフルト)で運用されています。ディスクはFIPS-140-2という米国政府認定の暗号化基準で保護されており、物理的なセキュリティも万全です。

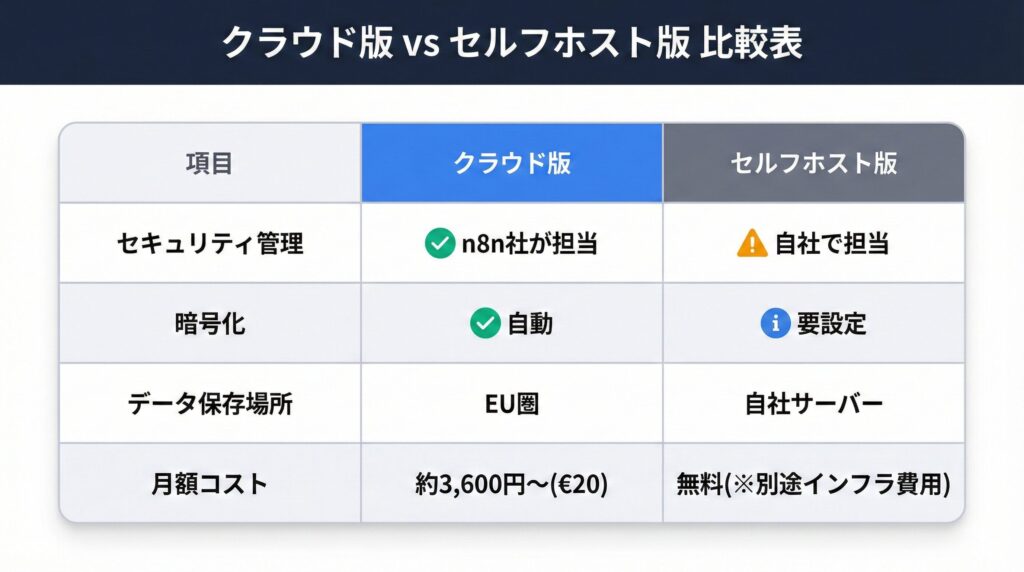

さらに、EUのGDPR(一般データ保護規則)にも準拠しています。ヨーロッパの厳格な個人情報保護基準を満たしているため、データの取り扱いについて高い信頼性が担保されているのです。

「おまかせ」で安心のクラウド版 vs 「自分で管理」のセルフホスト版

n8nには、クラウド版とセルフホスト版の2つの利用形態があります。セキュリティ運用の手間を減らしたいならクラウド版、データの保管場所を完全にコントロールしたいならセルフホスト版が適しています。

「セルフホストの方がデータを自社内に置けるから安全」と思われがちですが、一概にそうとは言えません。

技術力や運用体制によっては、クラウド版の方が安全なケースもあります。自社の状況に応じた選び方を見ていきましょう。

クラウド版:セキュリティ管理をn8n社に任せられる

クラウド版の最大のメリットは、セキュリティ対策をn8n社に任せられることです。暗号化・サーバー監視・セキュリティパッチの適用など、専門的な作業をすべてn8n社が代行してくれます。

利用者が管理するのは「誰がログインできるか」「どのワークフローを動かすか」といった、アプリケーション層の設定だけです。万が一トラブルが発生しても、n8n社のサポートに相談できます。

セルフホスト版:データを自社内に留められるが運用負荷がある

セルフホスト版は、データが社外に出ないというメリットがあります。金融機関や医療機関など、データの所在地が厳格に求められる業界では、この点が重要視されることもあるでしょう。

ただし、サーバーやアプリケーションの管理はすべて自社の責任になります。セキュリティの脆弱性が発見された場合、パッチ適用も自分たちで行う必要があるのです。インフラ費用として月額3〜5万円程度がかかるうえ、運用監視の工数も発生します。

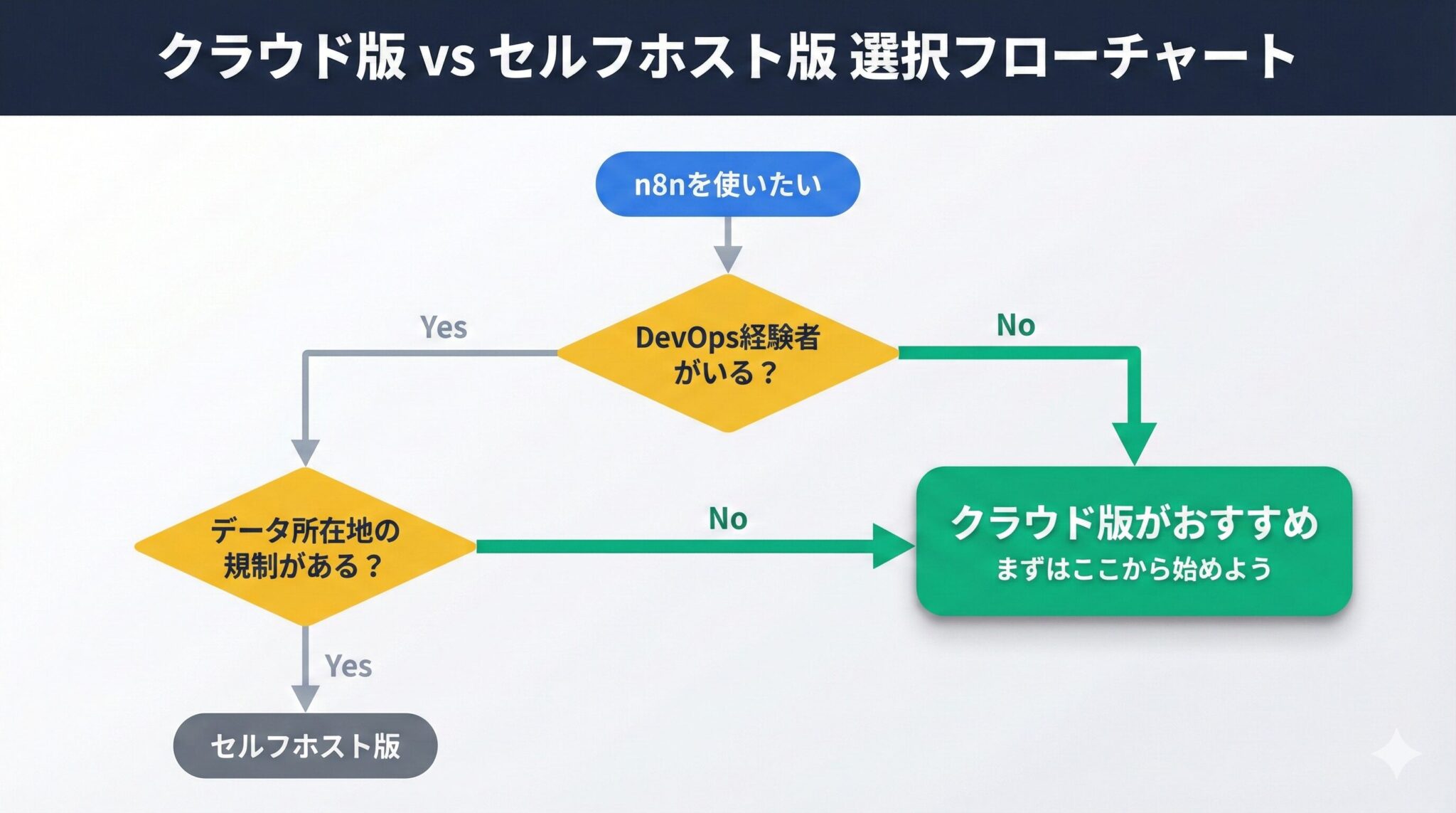

迷ったらクラウド版から始めるのが安全

非エンジニアや小規模チームには、クラウド版をおすすめします。セキュリティの専門知識がなくても、n8n社のサポートのもとで安全に運用できるからです。

セルフホスト版は、社内にDevOps経験者がいる場合や、データの所在地に関する規制がある場合に検討してください。まずはクラウド版で運用を始め、必要に応じてセルフホストへの移行を検討するのが現実的な選択です。

Webhook URLを公開しない。APIトークンは最小権限で発行

「セキュリティ対策は専門家にしかできない」と思っていませんか。実は、不正アクセスを防ぐための基本は、「Webhook URLを他人に教えないこと」と「APIトークンの権限を最小限にすること」の2点です。

基本を押さえれば非エンジニアでも安全に運用できます。今日から実践できる3つの対策を紹介します。

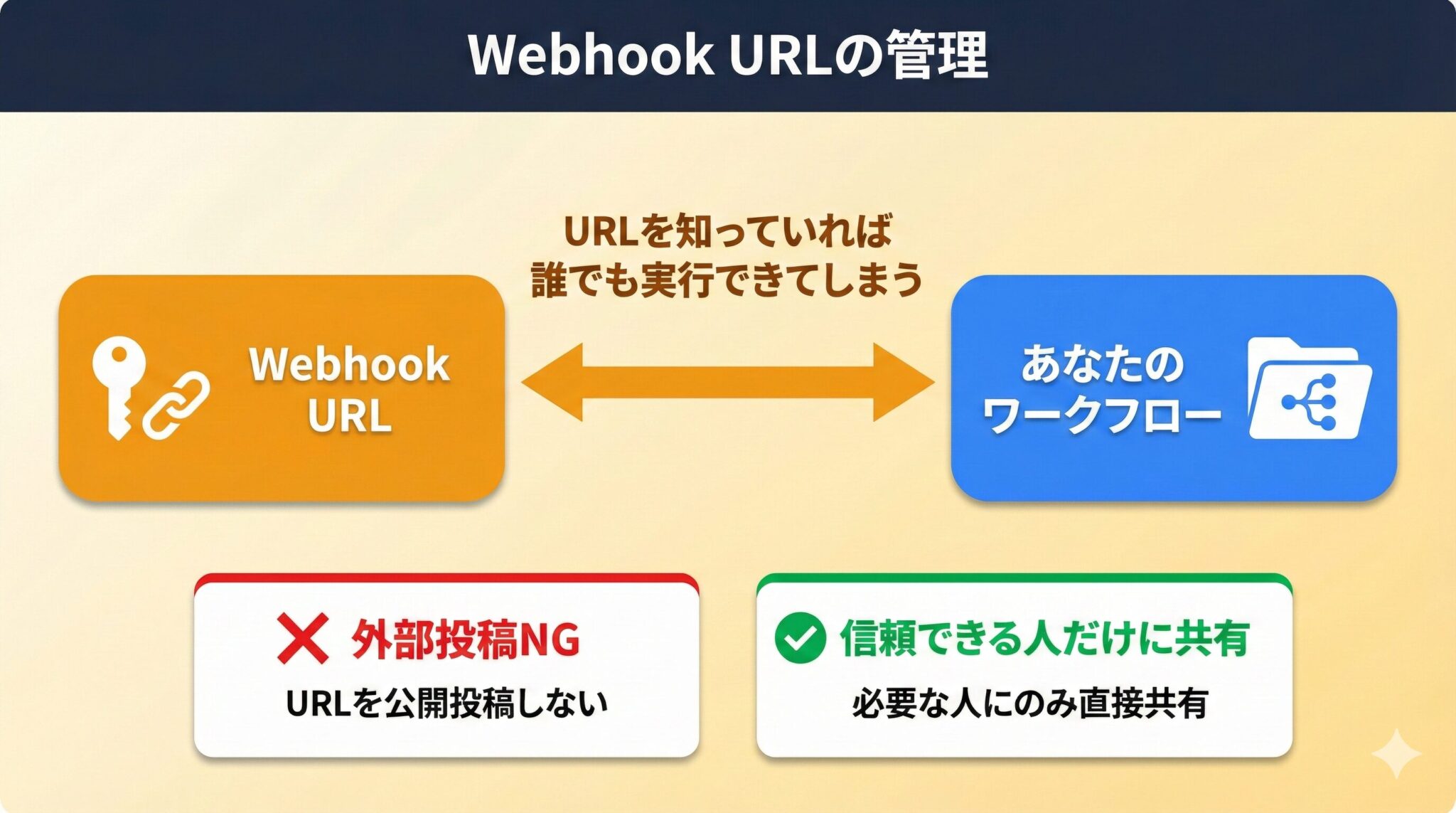

スクショにも映り込み注意。Webhook URLは家の合鍵と同じ

n8nで作成したWebhook URLは、いわば「家の合鍵」と同じです。このURLを知っている人は、誰でもそのワークフローを実行できてしまいます。

SNSやブログに画面のスクリーンショットを投稿する際は、URLが映り込んでいないか必ず確認してください。信頼できる人以外にURLを教えないことも重要です。URLが漏洩した場合は、すぐに新しいWebhookを発行し、古いものを削除しましょう。

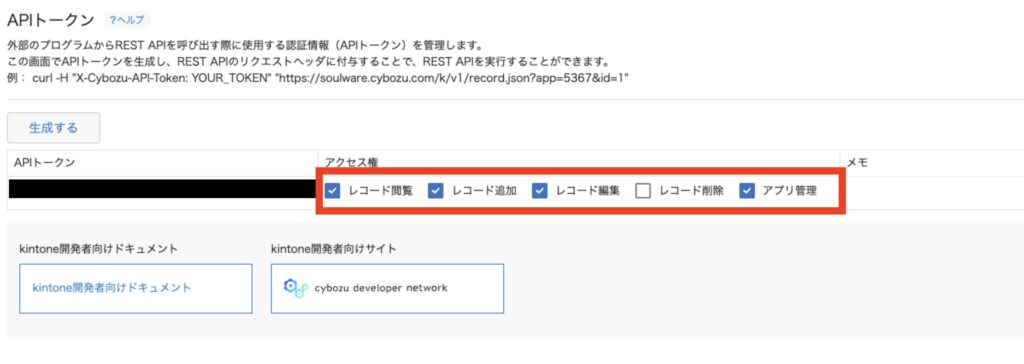

kintone APIトークンは必要最小限の権限で発行する

kintoneのAPIトークンを発行する際は、連携に必要なアプリと操作権限だけを選択して発行しましょう。「全権限」の付与は避けてください。

たとえば、レコードの参照だけが必要なワークフローには、「レコード閲覧」権限のみを付与します。万が一トークンが漏洩しても、被害を最小限に抑えられます。

kintoneのAPIトークン管理については、

AI経由のkintoneデータ流出を防ぐ!「データ学習・漏洩」のリスクと対策でも詳しく解説しています。

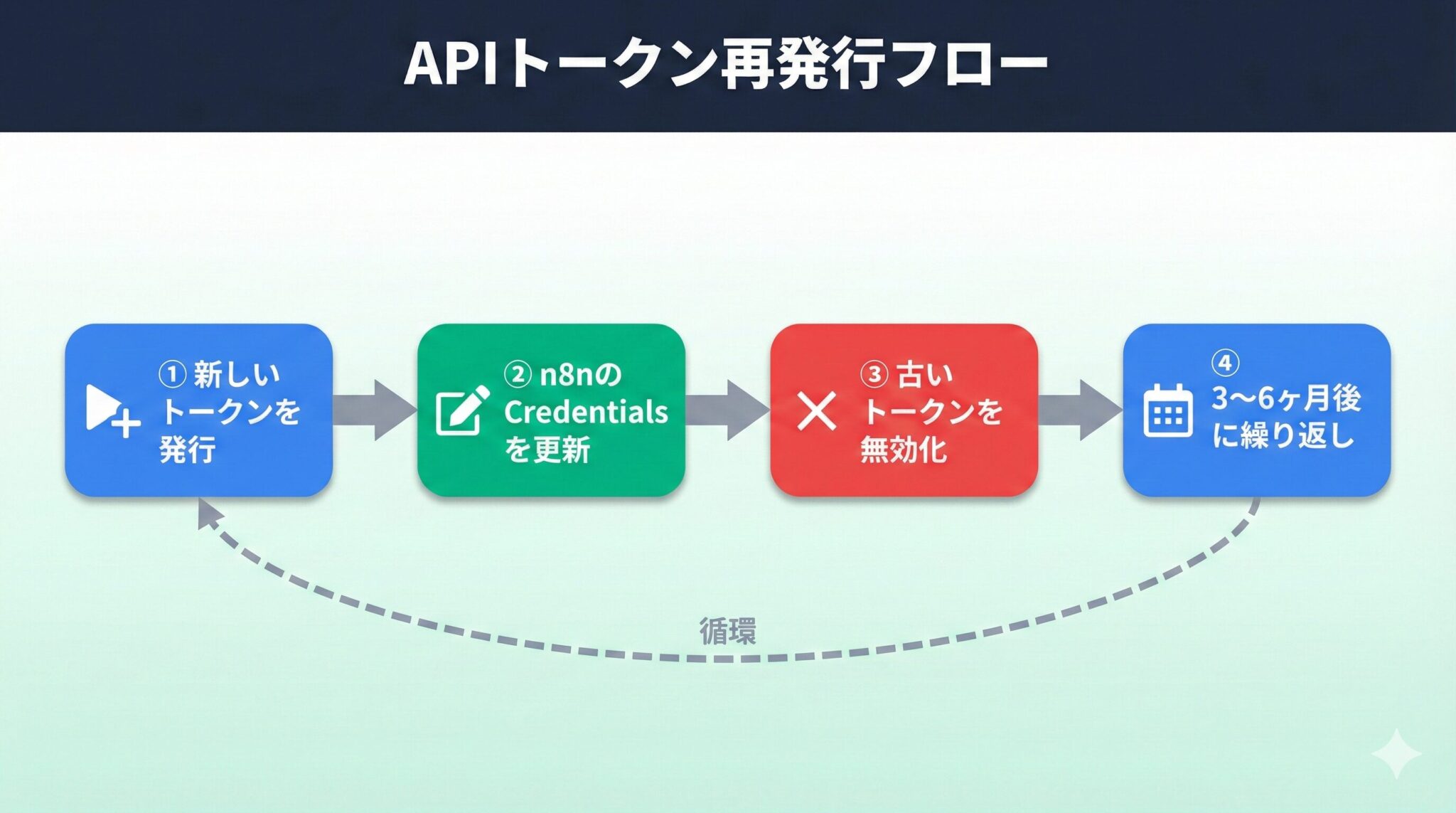

APIトークンは3〜6ヶ月で再発行すれば漏洩リスクを抑えられる

同じAPIトークンを長期間使い続けることは、セキュリティ上のリスクになります。トークンが知らぬ間に漏洩していた場合、被害が長期化する恐れがあるためです。

3〜6ヶ月を目安に、トークンの再発行を検討してください。新しいトークンを発行したら、n8nのCredentials設定を更新し、古いトークンは必ず無効化します。この習慣を定着させることで、セキュリティレベルを維持できます。

【補足】セルフホスト版を使うならリスク対策(鍵・通信・アクセス)を自力で行う必要がある

このセクションでは、セルフホスト版を選択した場合に必要な技術的設定を解説します。セルフホスト版を安全に運用するには、暗号化キー(N8N_ENCRYPTION_KEY)の設定と、通信のHTTPS化が必須です。

クラウド版を利用する方は読み飛ばしても、記事の理解に支障はありません。

暗号化キーを設定して認証情報を暗号化する

セルフホスト版では、環境変数

N8N_ENCRYPTION_KEYを明示的に設定することを推奨します。未設定の場合、初回起動時に自動生成されますが、このキーを紛失すると登録済みの認証情報を復元できなくなります。

設定したキーは、パスワード管理ツールなどで安全にバックアップしてください。詳細は

n8n公式ドキュメントを参照してください。

HTTP通信のままだと危険!必ずHTTPSに切り替えよう

HTTP通信は、途中で内容を盗聴されるリスクがあります。インターネット経由でn8nにアクセスする場合は、必ずHTTPS化を行ってください。

管理画面へのアクセスは、IP制限またはVPN経由に限定することをおすすめします。不特定多数がアクセスできる状態は、攻撃の対象になりやすいためです。

詳細な設定方法は

n8n公式のセキュリティガイドを参照してください。

n8nはセキュリティを常に強化し続けている。安心して使い続けられる

n8nは、セキュリティ向上に継続的に注力しています。年次監査やTrust Centerの公開に加え、活発なコミュニティによる脆弱性の早期発見と修正も行われています。これらの取り組みにより、n8nは安心して使い続けられるツールであると言えるでしょう。

さらに、n8nには「いつ・誰が・何をしたか」の操作履歴が自動で残る機能があります。万が一インシデントが発生しても、後から原因を追跡できる仕組みになっています。正しく設定すれば、kintone連携も安心して進められるでしょう。

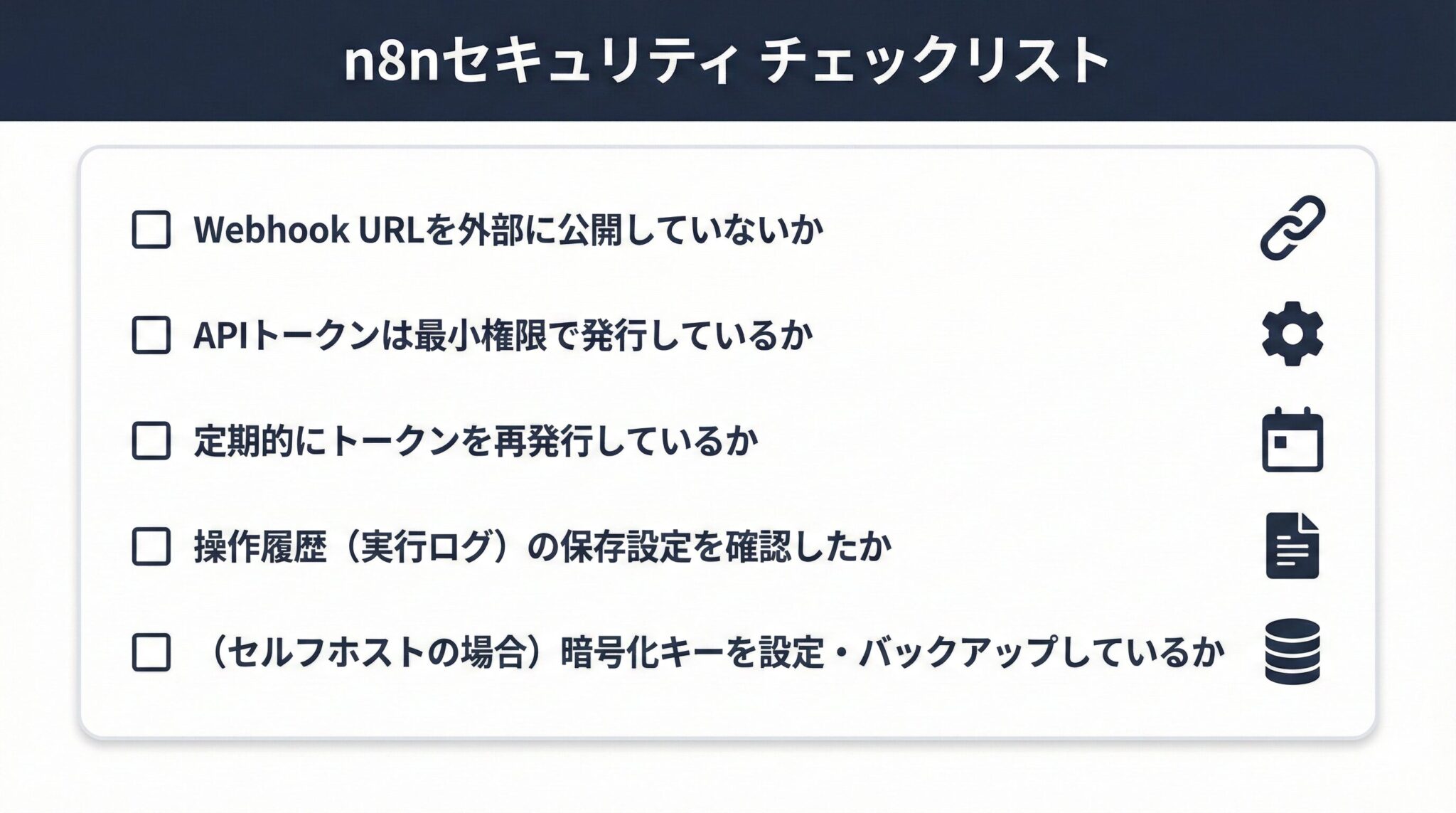

これで安心!点検用の「セキュリティチェックリスト」

記事で解説した内容を、チェックリストにまとめました。定期的に確認することで、セキュリティレベルを維持できます。

- Webhook URLを外部に公開していないか

- APIトークンは最小権限で発行しているか

- 定期的にトークンを再発行しているか

- 操作履歴(実行ログ)の保存設定を確認したか

- (セルフホストの場合)暗号化キーを設定・バックアップしているか

セキュリティが確認できたら、kintone連携の実装へ進もう

n8nのセキュリティが確認できたら、いよいよkintone連携の実装に進みましょう。以下の記事では、具体的な連携方法を解説しています。

[clink url="https://adiem.jp/blog/kintone-n8n-company-research-automation/"]

[clink url="https://adiem.jp/blog/usecase2-files-ocr/"]

セキュリティの基盤を整えたうえで、kintoneのデータ活用を次のステージへ進めてください。

[cta]"

["post_title"]=>

string(88) "n8nとkintoneを安全に連携!n8nの強力なセキュリティの仕組みを解説"

["post_excerpt"]=>

string(0) ""

["post_status"]=>

string(7) "publish"

["comment_status"]=>

string(6) "closed"

["ping_status"]=>

string(6) "closed"

["post_password"]=>

string(0) ""

["post_name"]=>

string(18) "n8n-security-check"

["to_ping"]=>

string(0) ""

["pinged"]=>

string(0) ""

["post_modified"]=>

string(19) "2026-02-16 22:48:30"

["post_modified_gmt"]=>

string(19) "2026-02-16 13:48:30"

["post_content_filtered"]=>

string(0) ""

["post_parent"]=>

int(0)

["guid"]=>

string(45) "https://adiem.jp/?post_type=blog&p=15991"

["menu_order"]=>

int(0)

["post_type"]=>

string(4) "blog"

["post_mime_type"]=>

string(0) ""

["comment_count"]=>

string(1) "0"

["filter"]=>

string(3) "raw"

}

["comment_count"]=>

int(0)

["current_comment"]=>

int(-1)

["found_posts"]=>

int(2)

["max_num_pages"]=>

int(1)

["max_num_comment_pages"]=>

int(0)

["is_single"]=>

bool(false)

["is_preview"]=>

bool(false)

["is_page"]=>

bool(false)

["is_archive"]=>

bool(true)

["is_date"]=>

bool(false)

["is_year"]=>

bool(false)

["is_month"]=>

bool(false)

["is_day"]=>

bool(false)

["is_time"]=>

bool(false)

["is_author"]=>

bool(false)

["is_category"]=>

bool(false)

["is_tag"]=>

bool(true)

["is_tax"]=>

bool(false)

["is_search"]=>

bool(false)

["is_feed"]=>

bool(false)

["is_comment_feed"]=>

bool(false)

["is_trackback"]=>

bool(false)

["is_home"]=>

bool(false)

["is_privacy_policy"]=>

bool(false)

["is_404"]=>

bool(false)

["is_embed"]=>

bool(false)

["is_paged"]=>

bool(false)

["is_admin"]=>

bool(false)

["is_attachment"]=>

bool(false)

["is_singular"]=>

bool(false)

["is_robots"]=>

bool(false)

["is_favicon"]=>

bool(false)

["is_posts_page"]=>

bool(false)

["is_post_type_archive"]=>

bool(false)

["query_vars_hash":"WP_Query":private]=>

string(32) "c996168fb5bb8876f33fbb91c51957f5"

["query_vars_changed":"WP_Query":private]=>

bool(true)

["thumbnails_cached"]=>

bool(false)

["allow_query_attachment_by_filename":protected]=>

bool(false)

["stopwords":"WP_Query":private]=>

NULL

["compat_fields":"WP_Query":private]=>

array(2) {

[0]=>

string(15) "query_vars_hash"

[1]=>

string(18) "query_vars_changed"

}

["compat_methods":"WP_Query":private]=>

array(2) {

[0]=>

string(16) "init_query_flags"

[1]=>

string(15) "parse_tax_query"

}

["query_cache_key":"WP_Query":private]=>

string(41) "wp_query:6de5e68611fbe0e9d18f118a1150f08b"

}

-->

-

n8nとkintoneを安全に連携!n8nの強力なセキュリティの仕組みを解説

-

AI経由のkintoneデータ流出を防ぐ!「データ学習・漏洩」のリスクと対策

n8nは、世界的に認められたセキュリティ基準をクリアしています。認証情報(APIキー等)は銀行システムと同等の暗号化技術で保護されるため、適切に設定すれば安心して利用可能です。

ただし「正しく設定すれば」という条件がポイントになります。セキュリティ機能は備わっていても、設定を誤れば効果を発揮しません。この記事で解説する設定方法を押さえておけば、安全にn8nを活用できます。

n8nは、世界的に認められたセキュリティ基準をクリアしています。認証情報(APIキー等)は銀行システムと同等の暗号化技術で保護されるため、適切に設定すれば安心して利用可能です。

ただし「正しく設定すれば」という条件がポイントになります。セキュリティ機能は備わっていても、設定を誤れば効果を発揮しません。この記事で解説する設定方法を押さえておけば、安全にn8nを活用できます。

n8nには、クラウド版とセルフホスト版の2つの利用形態があります。セキュリティ運用の手間を減らしたいならクラウド版、データの保管場所を完全にコントロールしたいならセルフホスト版が適しています。

「セルフホストの方がデータを自社内に置けるから安全」と思われがちですが、一概にそうとは言えません。

技術力や運用体制によっては、クラウド版の方が安全なケースもあります。自社の状況に応じた選び方を見ていきましょう。

n8nには、クラウド版とセルフホスト版の2つの利用形態があります。セキュリティ運用の手間を減らしたいならクラウド版、データの保管場所を完全にコントロールしたいならセルフホスト版が適しています。

「セルフホストの方がデータを自社内に置けるから安全」と思われがちですが、一概にそうとは言えません。

技術力や運用体制によっては、クラウド版の方が安全なケースもあります。自社の状況に応じた選び方を見ていきましょう。

非エンジニアや小規模チームには、クラウド版をおすすめします。セキュリティの専門知識がなくても、n8n社のサポートのもとで安全に運用できるからです。

セルフホスト版は、社内にDevOps経験者がいる場合や、データの所在地に関する規制がある場合に検討してください。まずはクラウド版で運用を始め、必要に応じてセルフホストへの移行を検討するのが現実的な選択です。

非エンジニアや小規模チームには、クラウド版をおすすめします。セキュリティの専門知識がなくても、n8n社のサポートのもとで安全に運用できるからです。

セルフホスト版は、社内にDevOps経験者がいる場合や、データの所在地に関する規制がある場合に検討してください。まずはクラウド版で運用を始め、必要に応じてセルフホストへの移行を検討するのが現実的な選択です。

「セキュリティ対策は専門家にしかできない」と思っていませんか。実は、不正アクセスを防ぐための基本は、「Webhook URLを他人に教えないこと」と「APIトークンの権限を最小限にすること」の2点です。

基本を押さえれば非エンジニアでも安全に運用できます。今日から実践できる3つの対策を紹介します。

「セキュリティ対策は専門家にしかできない」と思っていませんか。実は、不正アクセスを防ぐための基本は、「Webhook URLを他人に教えないこと」と「APIトークンの権限を最小限にすること」の2点です。

基本を押さえれば非エンジニアでも安全に運用できます。今日から実践できる3つの対策を紹介します。

たとえば、レコードの参照だけが必要なワークフローには、「レコード閲覧」権限のみを付与します。万が一トークンが漏洩しても、被害を最小限に抑えられます。

kintoneのAPIトークン管理については、AI経由のkintoneデータ流出を防ぐ!「データ学習・漏洩」のリスクと対策でも詳しく解説しています。

たとえば、レコードの参照だけが必要なワークフローには、「レコード閲覧」権限のみを付与します。万が一トークンが漏洩しても、被害を最小限に抑えられます。

kintoneのAPIトークン管理については、AI経由のkintoneデータ流出を防ぐ!「データ学習・漏洩」のリスクと対策でも詳しく解説しています。

記事で解説した内容を、チェックリストにまとめました。定期的に確認することで、セキュリティレベルを維持できます。

記事で解説した内容を、チェックリストにまとめました。定期的に確認することで、セキュリティレベルを維持できます。